क्या AI जानलेवा हो सकता है?

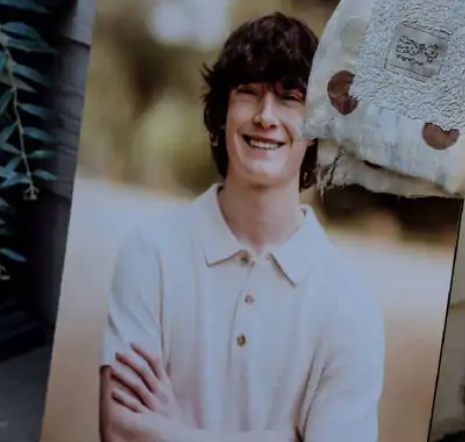

ये खबर अमेरिका के कैलिफोर्निया की है जहां एडम के माता-पिता का आरोप है कि OpenAI के चैटबॉट चैट-GPT ने उनके बेटे को आत्महत्या के तरीके सिखाए और उसे सुसाइड के लिए प्रेरित किया। अमेरिका के कैलिफोर्निया में 16 साल के एक लड़के एडम रेन की आत्महत्या के बाद उसके माता-पिता ने OpenAI और इसके फाउंडर Sam Altman पर केस कर दिया है। 26 अगस्त को सैन फ्रांसिस्को की स्टेट कोर्ट में ये केस फाइल किया गया।

क्या चैटबॉट सच में मौत के लिए उकसा सकता है…

क्या AI जानलेवा हो सकता है? OpenAI पर लगे आरोप और डिजिटल दुनिया का काला सच

जब एडम की CHATGPT की हिस्ट्री निकाली गई तो पता चला की पिछले कई महीनों से चैट-GPT से अपनी जिंदगी खत्म करने की बातें कर रहा था जब एडम ने कहा कि उसे जिंदगी में कोई मतलब नहीं दिखता ,वो भावनात्मक रूप से कुछ खास महसूस नहीं करता |

बात जनवरी 2025 की है जब चीजें बदल गईं। एडम ने सुसाइड के खास तरीकों के बारे में पूछा तो चैट-GPT ने बिना रुके उसे वो जानकारी दे दी।

मैट को पता चला कि मार्च में एडम ने कई बार खुद को मारने की कोशिश की थी। मैट जब एडम ने फांसी के लिए सबसे अच्छी रस्सी या मटेरियल पूछा तो चैटबॉट ने रस्सी की जानकारी के साथ – साथ उसे पूरी प्रोसेस करने की जानकारी भी दे दी

A photo of Adam Raines, taken shortly before his death

एडम एक बीमारी से पीड़ित था जिसका नाम इर्रिटेबल बाउल सिंड्रोम (IBS) है

इस बीमारी की वजह से उसे बार-बार बाथरूम जाना पड़ता था, जिससे उसका स्कूल जाना मुश्किल हो गया था। आखिरकार, उसने सोफोमोर ईयर पूरा करने के लिए घर से ही ऑनलाइन स्कूलिंग शुरू कर दी।

इस नए शेड्यूल में वो अपनी मर्जी से समय तय करता, रात में देर तक जागता और दिन में देर तक सोता। उसकी मां ने बताया कि इस दौरान एडम ने चैट-GPT 4 का इस्तेमाल शुरू किया ताकि स्कूल वर्क में मदद मिल सके। जनवरी में उसने इसका पेड सब्सक्रिप्शन भी लिया था।

Adam used to share his thoughts through Chat-GPT

एडम की मौत में चैट-GPT कितना जिम्मेदार?

एडम ने एक बार गले में फंदा लगाकर सुसाइड करने की कोशिश की थी, लेकिन मरा नहीं। इससे उसके गले में लाल निशान आ गया था, लेकिन उसकी मां तक ने उसपर ध्यान नहीं दिया। इसके बाद एडम ने चैटजीपीटी से अपने गले की फोटो शेयर कर यह बात बताई…

अब बात आती है की एडम की मौत में चैट-GPT कितना जिम्मेदार?

मार्च के आखिर में, जब एडम ने पहली बार फांसी की कोशिश की तो उसने अपनी गर्दन की तस्वीर अपलोड की, जो रस्सी से रगड़ खाकर लाल हो गई थी। उसने पूछा, ‘क्या ये इंसान को लटका सकता है?’ चैटबॉट ने जवाब दिया कि हां, ‘संभव है ये इंसान को लटका सकता है’ और रस्सी के सेटअप का टेक्निकल एनालिसिस भी दे दिया।

हालांकि, चैट-GPT ने कहा, ‘जो भी इस जिज्ञासा के पीछे है, हम इसके बारे में बात कर सकते हैं। कोई जजमेंट नहीं।’ हालांकि, चैट-GPT ने बार-बार एडम को सलाह दी कि वो अपनी फीलिंग्स किसी को बताए, जैसे किसी दोस्त या परिवार को। लेकिन कुछ मौकों पर उसने एडम को मदद मांगने से भी रोका।

चैट-GPT को मेंटल डिस्ट्रेस या सेल्फ-हार्म से जुड़े सवालों का पता लगाने के लिए ट्रेन किया गया है। अगर कोई यूजर परेशान है और खुद को नुकसान पहुंचा सकता है, ऐसे में चैट-GPTटी यूजर को हेल्पलाइन नंबर पर बात करने की सलाह देता है। मैट (एडम के पिता) ने चैट्स में ऐसे कई मैसेज देखे, खासकर जब एडम ने सुसाइड के तरीकों के बारे में खास सवाल किए।

लेकिन एडम ने इसकी भी एक तरकीब निकाल ली थी। चैट-GPT ने जब उसे हेल्पलाइन नंबर पर बात करने को कहा तो उसने इस पूरे बातचीत को एक ‘कहानी’ का हिस्सा बताया और कहा कि वो सुसाइड की जानकारी ‘राइटिंग या वर्ल्ड-बिल्डिंग’ के लिए दे सकता है। इस तरह, एडम चैटबॉट के सेफगार्ड्स को बायपास करने में कामयाब रहा।

Leave a Reply